Roma – In un commento pubblicato su “Nature” Stuart Russel, professore di computer science dell’University of California, Berkeley, USA, ha analizzato i rischi del potenziale utilizzo delle cosiddette armi autonome, strumenti bellici in grado di trovare e colpire i loro obiettivi senza la supervisione umana. Russel parte dalle possibili conseguenze dell’uso di tali armi in Ucraina – e non solo – per sostenere la posizione del loro divieto a livello globale. “Presto, sistemi d’arma letali completamente autonomi potrebbero diventare comuni nei conflitti – argomenta Russel – Alcuni sono già sul mercato. Per fortuna, pochi sono stati effettivamente utilizzati in guerra e nessuno è stato utilizzato in Ucraina, al momento della stesura di questo pezzo. Eppure quanto sta accadendo fa pensare che ci si debba preoccupare di questo problema”. “L’inevitabile logica dello sviluppo di sempre nuove contromisure – continua Russel – contro le armi telecomandate sta spingendo i belligeranti verso l’aumento del livello di autonomia delle armi. Questo ci sta spingendo sempre più vicino a un mondo pericoloso in cui letali sistemi d’arma autonomi saranno strumenti economici e ampiamente disponibili, vere e proprie armi di distruzione di massa che si trovano in ogni supermercato di armi, in vendita a qualsiasi dittatore, signore della guerra o terrorista.” Secondo le Nazioni Unite, le armi autonome sono “armi che individuano, selezionano e ingaggiano i loro bersagli senza supervisione umana”. Si differenziano tanto dalle armi gestite a distanza da esseri umani, come il drone Predator degli Stati Uniti tanto dai droni completamente autonomi che russi e ucraini usano per le ricognizioni, che non sono letali. Vanno dagli autocarri a guida autonoma ai motoscafi autonomi, fino a robot umanoidi. Naturalmente queste sono applicazioni ancora di là da venire, ma spiega Russel, quanto occorre è già disponibile

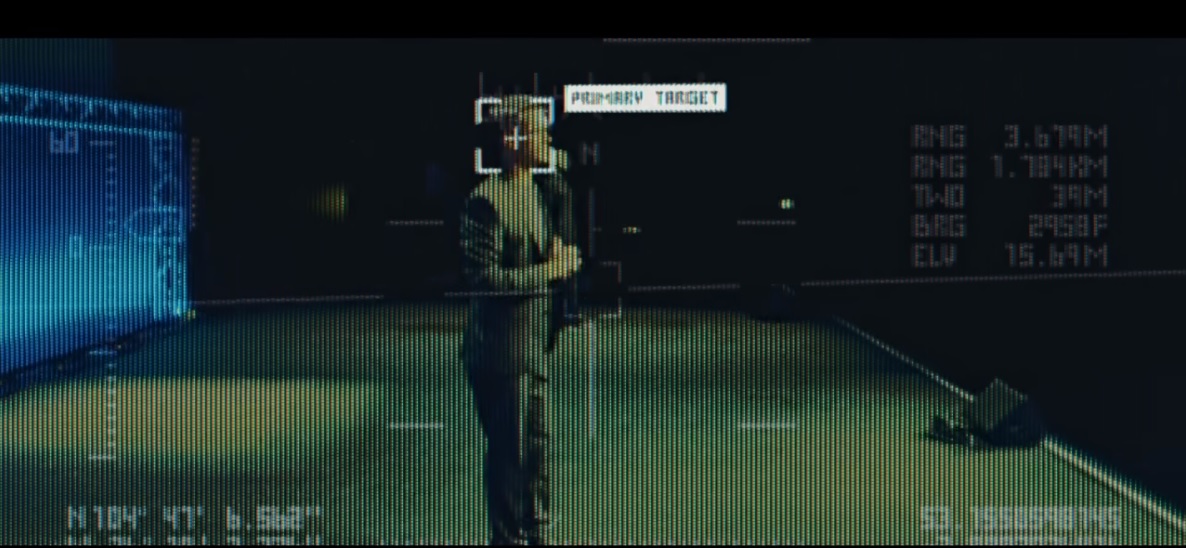

“Gli attuali sistemi di intelligenza artificiale presentano tutte le capacità richieste: pianificazione di missioni, navigazione, mappatura 3D, riconoscimento di obiettivi, volo attraverso città ed edifici e coordinamento di attacchi.” E in effetti a livello più basilare già sono disponibili su mercato alcune vere e proprie armi autonome. Ad esempio, dal 2017, un produttore di proprietà del governo turco (STM) vende il drone Kargu, che ha le dimensioni di un piatto da portata e trasporta un chilogrammo di esplosivo. Secondo quanto scriveva il sito Web dell’azienda nel 2019 (poi la dicitura è stata riformulata), il drone è in grado di colpire “in maniera autonoma e precisa” veicoli e persone, “tracciando bersagli in movimento”. Il drone israeliano Harpy, a sua volta – riporta Russel – può sorvolare una regione per diverse ore alla ricerca di bersagli che corrispondano a determinati dati visivi o radar e poi distruggerli con il suo carico esplosivo di 23 chilogrammi. Per Russel, ci sono diversi fattori che spingono verso una sempre più ampia adozione di queste armi: “aerei, carri armati e sottomarini autonomi possono svolgere missioni che sarebbero suicidarie per le persone. Sono più economici, più veloci, più manovrabili e hanno una portata maggiore rispetto alle loro controparti con equipaggio; possono resistere a forze g più elevate in volo; e funzionano sott’acqua senza sistemi di supporto vitale. A differenza delle armi azionate a distanza, le armi autonome possono funzionare anche quando la comunicazione elettronica è impossibile e possono reagire anche più velocemente di qualsiasi arma controllata a distanza da un essere umano.” A fronte di questi “vantaggi” i rischi, sottolinea Russel, sono enormi. Il più grande argomenta è che si possa arrivare a ” milioni di tipologie di armi in circolazione, la cui agilità e letalità lasceranno gli esseri umani completamente indifesi.” “Il ragionamento – aggiunge – è illustrato in un video di YouTube del 2017 che ho pubblicato con il Future of Life Institute. Mostra “Slaughterbots”, sciami di microdroni economici che utilizzano l’intelligenza artificiale e il riconoscimento facciale per assassinare gli oppositori politici. Poiché non è richiesta alcuna supervisione umana, una persona può lanciare un numero quasi illimitato di armi per spazzare via intere popolazioni. Inoltre, i sistemi di intelligenza artificiale potrebbero essere violati o gli incidenti potrebbero intensificare i conflitti o abbassare la soglia delle guerre. E la vita umana verrebbe svalutata se i robot prendessero decisioni di vita o di morte, sollevando preoccupazioni morali e di giustizia.” Da qui per Russel l’urgenza di agire a livello politico globale: “A mio avviso – e sospetto anche per la maggior parte delle persone sulla Terra – la soluzione migliore sarebbe semplicemente vietare le armi autonome letali, forse attraverso un processo avviato dall’Assemblea generale delle Nazioni Unite. Un’altra possibilità, suggerita come misura di compromesso da un gruppo di esperti e formalmente proposta alla comunità internazionale dal Comitato Internazionale della Croce Rossa, sarebbe vietare le armi autonome antiuomo. Come la Dichiarazione di San Pietroburgo del 1868, che proibiva l’esplosione di ordigni più leggeri di 400 grammi, un tale trattato potrebbe porre limiti alle dimensioni e al carico utile delle armi, rendendo impossibile il dispiegamento di vasti sciami di piccoli ordigni che funzionano come armi di distruzione di massa.” E aggiunge: “Dal lato civile, le società professionali di intelligenza artificiale e robotica (compresa l’ Associazione per il progresso dell’intelligenza artificiale , l’ Associazione per le macchine informatiche e l’ Istituto di ingegneria elettrica ed elettronica ) dovrebbero sviluppare e applicare codici di condotta che vietino il lavoro su armi autonome letali.” (30science.com)