Roma – Gli esseri umani non hanno mostrato particolari abilità nel distinguere le voci umane da quelle generate dall’intelligenza artificiale, IA, ma il cervello ha dimostrato di rispondere in modo diverso all’ascolto di voci umane e generate dall’IA. Lo rivela uno studio presentato al Federation of European Neuroscience Societies, FENS, Forum 2024 dalla ricercatrice di dottorato, Christine Skjegstad e realizzato dalla stessa assieme a Sascha Frühholz, entrambi del Dipartimento di Psicologia dell’Università di Oslo, UiO, in Norvegia. “Sappiamo già che le voci generate dall’intelligenza artificiale sono diventate così avanzate da essere quasi indistinguibili dalle vere voci umane”, ha detto Skjegstad. “È ora possibile clonare la voce di una persona a partire da pochi secondi di registrazione, e i truffatori hanno usato questa tecnologia per imitare una persona cara in difficoltà e ingannare le vittime con trasferimenti di denaro”, ha continuato Skjegstad.

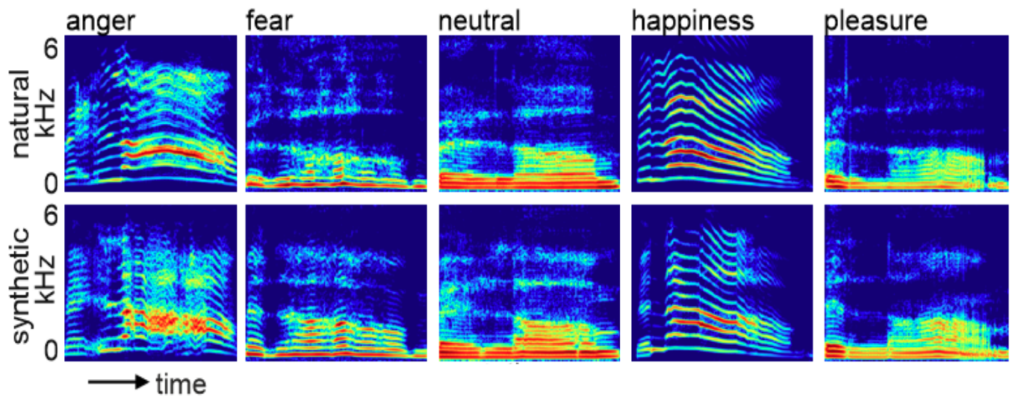

Spettrogrammi per dimostrare la somiglianza tra le voci umane e quelle dell’intelligenza artificiale

CREDITO

Forum FENS / Christine Skjegstad

“Mentre gli esperti di apprendimento automatico hanno sviluppato soluzioni tecnologiche per individuare le voci dell’intelligenza artificiale, si sa molto meno della risposta del cervello umano a queste voci”, ha aggiunto Skjegstad. La ricerca ha coinvolto 43 individui a cui è stato chiesto di ascoltare voci umane e generate dall’intelligenza artificiale che esprimevano cinque diverse emozioni: neutro, rabbia, paura, felicità, piacere. È stato chiesto loro di identificare le voci come sintetiche o naturali, mentre il loro cervello veniva studiato con la risonanza magnetica funzionale, fMRI, che viene utilizzata per rilevare i cambiamenti del flusso sanguigno all’interno del cervello, indicando quali parti del cervello sono attive. Ai partecipanti è stato anche chiesto di valutare le caratteristiche delle voci ascoltate in termini di naturalezza, affidabilità e autenticità. Le persone che hanno preso parte allo studio hanno identificato correttamente le voci umane solo nel 56% dei casi e le voci dell’intelligenza artificiale nel 50,5% dei casi, il che significa che erano ugualmente incapaci di identificare entrambi i tipi di voci. Le persone avevano maggiori probabilità di identificare correttamente una voce AI “neutra” come AI, con il 75% in più rispetto al 23% che riusciva a identificare correttamente una voce umana neutra come umana, suggerendo che le persone ritengono che le voci neutre siano più simili all’AI. Le voci neutre femminili di IA sono state identificate correttamente più spesso di quelle maschili. Per le voci umane felici, il tasso di identificazione corretta è stato del 78%, rispetto a solo il 32% per le voci AI felici, suggerendo che le persone associano la felicità a voci più simili a quelle umane. Sia le voci neutre dell’IA che quelle umane sono state percepite come meno naturali, affidabili e autentiche, mentre le voci felici umane sono state percepite come più naturali, affidabili e autentiche. Tuttavia, esaminando le immagini cerebrali, i ricercatori hanno scoperto che le voci umane suscitano risposte più forti nelle aree del cervello associate alla memoria, nell’ippocampo destro, e all’empatia, nel giro frontale inferiore destro. Le voci dell’intelligenza artificiale hanno suscitato risposte più forti nelle aree legate all’individuazione degli errori, nella corteccia cingolata medio-anteriore destra, e alla regolazione dell’attenzione, nella corteccia prefrontale dorsolaterale destra. “La mia ricerca indica che non siamo molto bravi nell’identificare con precisione se una voce è umana o generata dall’intelligenza artificiale”, ha dichiarato Skjegstad. I partecipanti hanno anche spesso espresso la difficoltà di distinguere le voci, il che suggerisce che l’attuale tecnologia vocale dell’IA può imitare le voci umane al punto che è difficile per le persone distinguerle in modo affidabile. “I risultati indicano anche una distorsione nella percezione: è più probabile che le voci neutre vengano identificate come generate dall’IA e che le voci felici vengano identificate come più umane, indipendentemente dal fatto che lo siano effettivamente”, ha spiegato Skjegstad. “Ciò è avvenuto soprattutto per le voci neutre femminili dell’intelligenza artificiale, forse perché abbiamo familiarità con assistenti vocali femminili come Siri e Alexa”, ha proseguito Skjegstad.”Sebbene non siamo molto bravi a identificare le voci umane da quelle dell’intelligenza artificiale, sembra esserci una differenza nella risposta del cervello”, ha osservato Skjegstad. “Le voci dell’intelligenza artificiale possono suscitare una maggiore attenzione, mentre le voci umane possono suscitare un senso di parentela”, ha aggiunto Skjegstad. I ricercatori intendono ora studiare se i tratti della personalità, ad esempio l’estroversione o l’empatia, rendano le persone più o meno sensibili a notare le differenze tra le voci umane e quelle dell’intelligenza artificiale. (30Science.com)