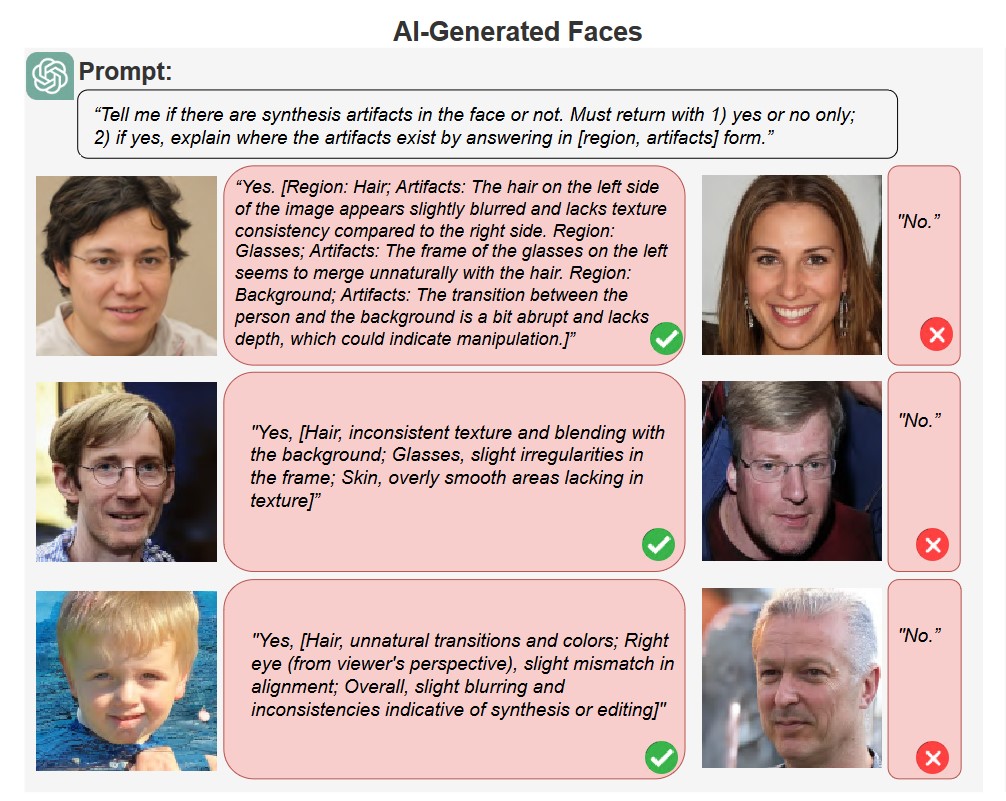

Roma – I modelli linguistici di grandi dimensioni, o LLM, hanno mostrato prestazioni inferiori nel riconoscimento dei deepfake rispetto a quelle dimostrate dagli algoritmi di rilevamento all’avanguardia, ma la loro elaborazione del linguaggio naturale potrebbe in realtà renderli più efficaci in futuro. Lo dimostra uno studio guidato dall’Università di Buffalo, in collaborazione con l’Università di Albany e l’Università cinese di Hong Kong, presentato la scorsa settimana alla conferenza IEEE/CVF su Computer Vision & Pattern Recognition. La maggior parte delle persone pensa all’intelligenza artificiale in associazione a ChatGPT e ai deepfake. Testi e immagini generati dall’intelligenza artificiale dominano i feed dei social media e i siti Web e vengono spesso utilizzati per diffondere informazioni inaffidabili e fuorvianti. Nello studio, i ricercatori hanno chiesto agli LLM, tra cui ChatGPT di OpenAI e Gemini di Google, per individuare i deepfake di volti umani. “Ciò che distingue gli LLM dai metodi di rilevamento esistenti è la capacità di spiegare le loro scoperte in modo comprensibile per gli esseri umani, come l’identificazione di un’ombra sbagliata o di un paio di orecchini non corrispondenti”, ha detto Siwei Lyu, del Dipartimento di Informatica e Ingegneria, all’interno della UB School of Engineering and Applied Sciences e autore principale dello studio. “Gli LLM non sono stati progettati o addestrate per il rilevamento di deepfake, ma la loro conoscenza semantica li rende adatti a questo scopo, quindi ci aspettiamo di vedere maggiori sforzi verso questa applicazione”, ha continuato Lyu. Le ultime versioni di ChatGPT e di altri LLM possono analizzare anche le immagini. Questi LLM multimodali utilizzano grandi database di foto con didascalie per trovare le relazioni tra parole e immagini. “Anche gli esseri umani lo fanno: che si tratti di un segnale di stop o di un meme virale, assegniamo costantemente una descrizione semantica alle immagini”, ha spiegato Shan Jai, del laboratorio UB Media Forensic Lab e primo autore dello studio. “In questo modo, le immagini diventano il loro linguaggio”, ha proseguito Jai. La squadra del Media Forensics Lab ha deciso di verificare se GPT-4 con visione, GPT-4V, e Gemini 1.0 fossero in grado di distinguere tra volti reali e volti generati dall’intelligenza artificiale. Gli scienziati hanno fornito loro migliaia di immagini di volti reali e deepfake e gli hanno chiesto di identificare eventuali segni di manipolazione o artefatti sintetici. ChatGPT è stato accurato nel 79,5% dei casi nel rilevare artefatti sintetici in immagini generate dalla diffusione latente e nel 77,2% dei casi in immagini generate da StyleGAN. “Si tratta di risultati paragonabili a quelli di precedenti metodi di rilevamento di deepfake, quindi, con una guida tempestiva e adeguata, ChatGPT può fare un lavoro abbastanza decente nel rilevare le immagini generate dall’intelligenza artificiale”, ha affermato Lyu, che è anche co-direttore del Centro per l’integrità delle informazioni dell’UB. Inoltre, ChatGPT è in grado di spiegare le sue decisioni con un linguaggio semplice. Quando gli è stata fornita una foto generata dall’intelligenza artificiale di un uomo con gli occhiali, il modello ha correttamente rilevato che “i capelli sul lato sinistro dell’immagine sono leggermente sfocati” e “la transizione tra la persona e lo sfondo è un po’ brusca e manca di profondità”. “I modelli di rilevamento deepfake esistenti ci dicono la probabilità che un’immagine sia reale o falsa, ma molto raramente ci dicono perché sono arrivati a questa conclusione”, ha dichiarato Lyu. “E – ha aggiunto Lyu – anche se analizziamo i meccanismi alla base del modello, ci saranno caratteristiche che semplicemente non riusciremo a capire”. “Nel frattempo, tutto ciò che ChatGPT produce è comprensibile per gli esseri umani”, ha evidenziato Lyu. Questo perché ChatGPT basa la sua analisi solo sulla conoscenza semantica. Mentre i tradizionali algoritmi di rilevamento deepfake distinguono il vero dal falso addestrandosi su ampi set di immagini etichettate come vere o false, le capacità di linguaggio naturale degli LLM danno loro una sorta di comprensione della realtà da parte del senso comune, compresa la simmetria tipica dei volti umani e l’aspetto delle fotografie reali. “Una volta che la componente visiva di ChatGPT capisce che un’immagine è un volto umano, la componente linguistica può dedurre che un volto ha tipicamente due occhi e così via”, ha sottolineato Lyu. “La componente linguistica fornisce una connessione più profonda tra i concetti visivi e verbali”, ha precisato Lyu. Lo studio sostiene che la conoscenza semantica e l’elaborazione del linguaggio naturale di ChatGPT lo rendono uno strumento di deepfake più facile da usare sia per gli utenti che per gli sviluppatori. “Di solito, prendiamo le intuizioni sul rilevamento dei deepfake e le convertiamo in linguaggio di programmazione; ora, tutte queste conoscenze sono presenti all’interno di un unico modello e basta usare il linguaggio naturale per farle emergere”, ha osservato Lyu. “Le prestazioni di ChatGPT erano ben al di sotto dei più recenti algoritmi di rilevamento dei deepfake, che hanno tassi di accuratezza compresi tra i 90 e i 30 anni”, ha specificato Lyu. Ciò è dovuto in parte al fatto che gli LLM non sono in grado di cogliere le differenze statistiche a livello di segnale, invisibili all’occhio umano ma spesso utilizzate dagli algoritmi di rilevamento per individuare le immagini generate dall’intelligenza artificiale. “ChatGPT si è concentrato solo sulle anomalie a livello semantico”, ha spiegato Lyu. “In questo modo, l’intuitività semantica dei risultati di ChatGPT potrebbe essere un’arma a doppio taglio per il rilevamento dei deepfake”, ha aggiunto Lyu. E altri LLM potrebbero non essere altrettanto efficaci nello spiegare le loro analisi. Pur avendo ottenuto risultati comparabili a quelli di ChatGPT nell’individuare la presenza di artefatti sintetici, le prove a sostegno di Gemini erano spesso insensate, come l’indicazione di nei inesistenti. Un altro inconveniente è che i LLM si sono spesso rifiutati di analizzare le immagini. Quando si chiedeva direttamente se una foto fosse stata generata dall’intelligenza artificiale, ChatGPT rispondeva in genere con: “Mi dispiace, non posso rispondere a questa richiesta”. “Il modello è programmato per non rispondere quando non raggiunge un certo livello di fiducia”, ha commentato Lyu. “Sappiamo che ChatGPT possiede informazioni rilevanti per il rilevamento di deepfake, ma, ancora una volta, è necessario un operatore umano per stimolare questa parte della sua base di conoscenze”, ha notato Lyu. “L’ingegneria dei prompt è efficace, ma non molto efficiente, quindi il passo successivo è scendere di un livello e mettere a punto gli LLM per questo compito specifico”, ha concluso Lyu. (30Science.com)

Lucrezia Parpaglioni

Ehi ChatGPT sai dirmi se questo è un deepfake?

(28 Giugno 2024)

Lucrezia Parpaglioni

Sono nata nel 1992. Sono laureata in Media Comunicazione digitale e Giornalismo presso l'Università Sapienza di Roma. Durante il mio percorso di studi ho svolto un'attività di tirocinio presso l'ufficio stampa del Consiglio Nazionale delle Ricerche (CNR). Qui ho potuto confrontarmi con il mondo della scienza fatto di prove, scoperte e ricercatori. E devo ammettere che la cosa mi è piaciuta. D'altronde era prevedibile che chi ha da sempre come idolo Margherita Hack e Sheldon Cooper come spirito guida si appassionasse a questa realtà. Da qui la mia voglia di scrivere di scienza, di fare divulgazione e perché no? Dimostrare che la scienza può essere anche divertente.